|

|

|

|

|

新闻资讯

|

|

| 视频新闻 | |

| 协会新闻 | |

| 国内新闻 | |

| 国际新闻 | |

|

协会通告 |

| 河北省中小企业技术创新服务协会 |

| 河北省中小企业技术创新服务协会 |

| 河北省中小企业技术创新服务协会 |

| 河北省中小企业技术创新服务协会 |

| 河北省中小企业技术创新服务协会 |

| 河北省中小企业技术创新服务协会 |

| 河北省中小企业技术创新服务协会 |

|

供求信息 |

| 建设银行:创新推进普惠金融 服务 |

| 河北 省级中小企业创业辅导基地开 |

| 具备五个条件可申报河北省中小企 |

| 农行河北分行助力小微企业发展 |

| 资金投资合作 |

| 无边界培训:企业人力资本新引擎 |

| 技术创新方法培训服务 |

| 科技查新咨询服务 |

近年来,随着深度学习技术的发展,医疗人工智能(医疗AI)在基于视网膜图像判定人体健康状况、诊断潜在眼部和全身性疾病等领域,具有巨大潜力。然而,AI模型的开发往往需要大量的标记,这些标记通常只针对特定任务,因而对不同临床应用的泛化能力十分有限。

近日,在nature杂志上发表的一篇研究介绍了基础模型RETFound——一个针对视网膜图像的大模型。RETFound能从未标记的视网膜图像中学习可泛化的表征,具体而言,RETFound通过自监督学习的方法在160万张未标记的视网膜图像上进行训练,然后通过微调来适应具有明确标记的疾病检测任务。科学家们展示了微调后的RETFound在诊断和预测眼部疾病方面的能力,以及在较少标记数据的情况下,对于复杂的全身性疾病(如心力衰竭和心肌梗死)的预测能力,发现它的表现始终优于其他模型。

总之,RETFound提供了一个可泛化的解决方案,能提高模型性能并减轻专家标记工作的负担,从而实现了基于视网膜图像的AI更广泛的临床应用。

图1:论文封面。图源:nature官网

从心灵的窗户窥见疾病的端倪

毋庸置疑,医疗AI的发展之迅速,在不少医疗领域已达到,甚至超越了临床专家的准确度,比如在进行对威胁视力的视网膜疾病的转诊建议、胸部X射线图像的病理学检测等。但上述模型是基于大量高质量的标记开发完成的,这样的标记需要大量的专家评估,对医生而言是一项繁重的工作负担。更为重要的是,由于具有相关领域知识的专家十分稀缺,无法满足AI对于标记的要求,这也导致大量医疗数据未被标记,无法被有效利用。

对此,深度学习中的自监督学习(self-supervised learning,SSL),或可提供解决思路。

SSL通过直接从数据中获取监督信号来缓解数据效率低下的问题,而不是依靠专家标记。SSL训练模型执行不需要标签或可以自动生成标签的“前置任务”,该过程中模型利用大量未标记数据来学习通用特征的表征,从而轻松适应更具体的任务。在预训练阶段之后,模型将针对特定的下游任务进行微调,例如分类或细分。在各种计算机视觉任务中,SSL模型的性能优于基于监督学习的迁移学习(例如,使用ImageNet和分类标签来预训练模型)。除了提高标记的效率之外,在对来自不同领域的新数据进行测试时,基于SSL的模型比监督模型的表现更好。

强大的泛化表征能力,加之其在许多下游任务中通过微调模型实现的高性能,种种证据皆表明SSL在数据丰富、任务多样化但标记稀缺的医疗AI领域中具有巨大潜力。

彩色眼底摄影(colour fundus photography,CFP)和光学相干断层扫描(optical coherence tomography,OCT)是眼科最常见的成像方式,此类视网膜图像在常规临床实践中得以迅速积累。除了能显示与眼部疾病相关的临床特征外,这些图像对于全身性疾病的诊断也很有价值。例如,视神经和视网膜内层摄影提供了中枢神经系统组织的非侵入性影像,从而为医生提供了了解病人神经病变的窗口。同样地,视网膜血管的几何形状也有利于医生深入了解其他器官(如心脏和肾脏)。

视网膜图像+SSL模型,一个基于自监督学习的视网膜图像基础模型由此诞生了。

RETFound:视网膜图像基础模型

在这项研究中,科学家通过SSL利用大量未标记的视网膜图像构建了RETFound,并用其促进多种疾病的检测。

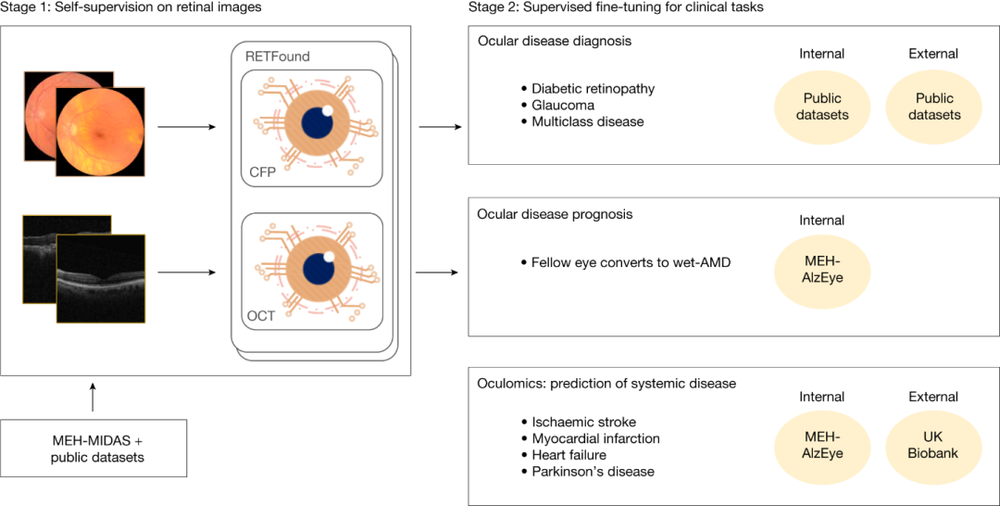

具体而言,科研团队开发了两个独立的RETFound模型,一个基于CFP,另一个基于OCT,通过掩码自编码器(一种SSL技术),依次对自然图像(ImageNet-1k)、Moorfields糖尿病图像数据集(MEH-MIDAS)的视网膜图像和公共数据(共计904170个CFP数据和736442个OCT数据)进行分析。

然后,科学家通过使用特定任务标签微调RETFound,使RETFound可以适应一系列具有挑战性的诊断和预测任务,并验证其性能。

图2.RETFound基础模型的开发和评估示意图。阶段1:使用来自MEH-MIDAS的CFP和OCT图像以及公共数据集,通过SSL构建RETFound。阶段2:通过内部和外部评估的监督学习使RETFound适应下游任务。图源:论文

图2概述了RETFound的构建和应用。为了构建RETFound,科学家使用了904170幅CF

|